Salut les amis de la technologie et de l’innovation ! Franchement, vous êtes-vous déjà arrêtés un instant pour admirer l’ingéniosité cachée derrière nos appareils du quotidien ?

Moi, la passion pour l’électronique me vient de là, de cette curiosité insatiable de comprendre comment tout cela fonctionne. Et quand on se penche sur l’histoire de la conception des circuits, c’est une véritable épopée humaine qui se révèle.

Des premiers balbutiements aux merveilles miniaturisées d’aujourd’hui, chaque avancée, chaque “cas” de conception, est le fruit d’une vision audacieuse et d’un travail acharné.

Imaginez un peu le génie qu’il a fallu pour transformer de simples idées en des systèmes complexes qui ont littéralement modelé notre monde ! On explore non seulement le passé, mais on décrypte aussi les tendances actuelles et futures qui en découlent, comme l’intégration de l’intelligence artificielle directement dans les puces ou la quête inlassable de circuits toujours plus économes en énergie et plus compacts.

C’est fascinant de voir comment les leçons d’hier façonnent les innovations de demain. J’ai personnellement eu l’occasion de me plonger dans des archives et des récits d’ingénieurs qui m’ont soufflé.

C’est une histoire continue, vibrante et pleine de rebondissements. Alors, si vous êtes prêts à plonger avec moi dans les coulisses de ces créations emblématiques et à comprendre ce qui nous attend, on va voir ça ensemble !

Accrochez-vous, on va découvrir tout cela en détail.

L’aube de l’électronique : Les premiers pas fascinants

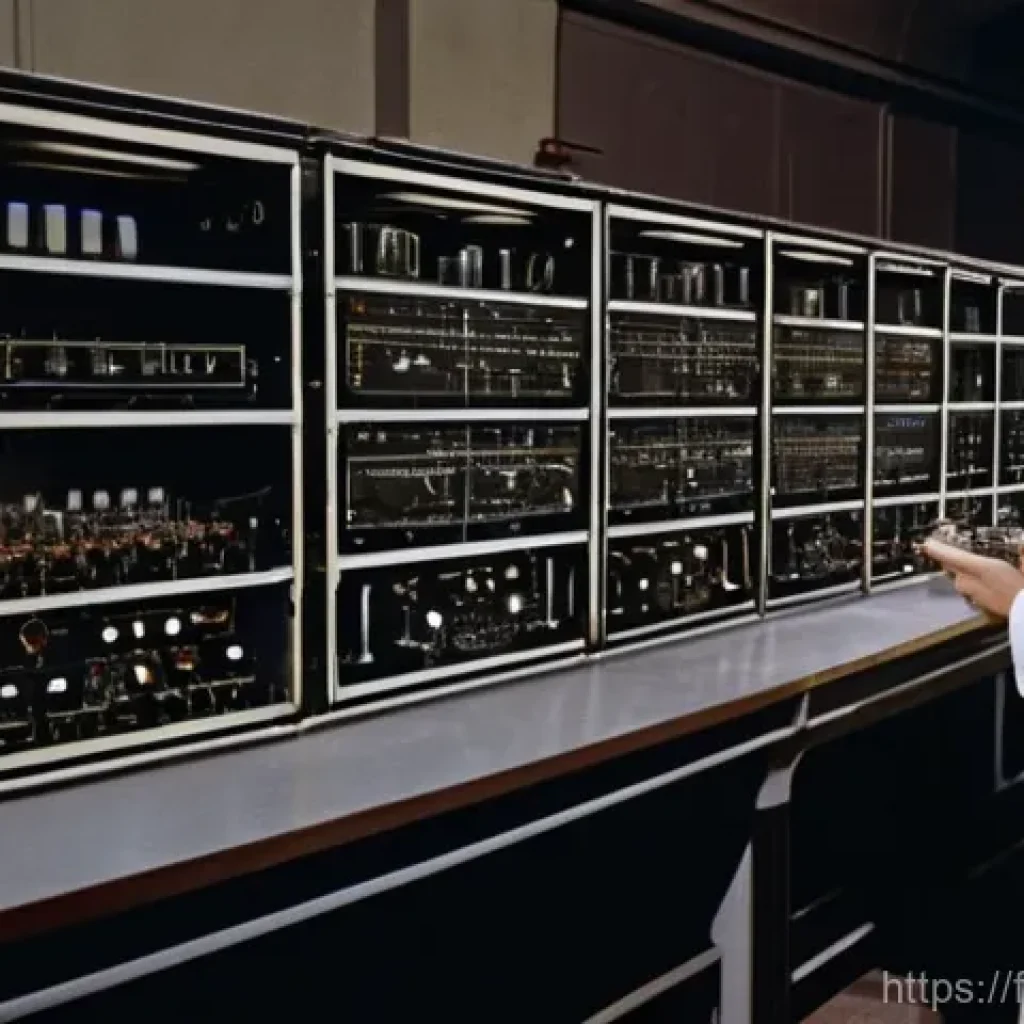

Vous savez, quand on se penche sur les origines de l’électronique, on réalise à quel point l’audace et l’ingéniosité humaine ont toujours été au cœur de cette aventure. Avant les puces que nous connaissons, il y avait les tubes à vide, ces drôles d’ampoules qui faisaient le travail de nos transistors actuels. J’imagine les ingénieurs de l’époque, les yeux rivés sur ces composants fragiles mais révolutionnaires, essayant de dompter l’électricité pour la faire travailler à leur guise. Pensez au premier ENIAC, une machine gigantesque qui occupait des pièces entières, une véritable cathédrale technologique qui calculait à une vitesse folle pour son temps, mais qui consommait une énergie colossale et générait une chaleur incroyable. C’est une période où la créativité était sans limites, malgré les contraintes matérielles. Moi, quand je découvre ces histoires, je me dis que le chemin parcouru est tout simplement incroyable. Ces pionniers ont jeté les bases de tout ce que nous utilisons aujourd’hui, et sans leur persévérance, nos smartphones, nos ordinateurs, nos voitures connectées n’existeraient tout simplement pas. C’est une leçon d’humilité et d’inspiration pour tous ceux qui aiment la technologie.

Les tubes à vide : Les géants fragiles

Les tubes à vide, ou lampes, étaient les héros méconnus des premières décennies de l’électronique. Ils amplifiaient les signaux, servaient d’interrupteurs, et étaient essentiels à la radio, à la télévision et aux premiers ordinateurs. Leurs dimensions étaient imposantes et leur durée de vie, relativement courte, nécessitait des remplacements fréquents. Mais imaginez l’excitation de ces ingénieurs lorsqu’ils voyaient une information transiter par ces composants pour la première fois ! C’était magique. Leurs défis étaient quotidiens, entre la chaleur dégagée et la fiabilité, chaque circuit était une œuvre d’art exigeant une précision d’orfèvre. J’ai eu l’occasion de voir d’anciens appareils équipés de ces tubes, et on sentait une âme, une chaleur qui émanait de ces machines, bien différente de la froideur de nos circuits imprimés modernes.

Les premiers calculateurs : Une ère de gigantisme

Les premiers ordinateurs, à l’instar de l’ENIAC, étaient des monstres de technologie et d’ingénierie. Ils occupaient des salles entières, pesaient des tonnes et étaient composés de milliers de tubes à vide, de relais et de kilomètres de câbles. Ces machines étaient le fruit d’efforts monumentaux, souvent pour des applications militaires ou scientifiques complexes. Le simple fait de les maintenir en fonctionnement était un exploit ! On dit qu’une panne de tube pouvait prendre des jours à être localisée. Cela nous rappelle à quel point la miniaturisation et la fiabilité que nous tenons pour acquises aujourd’hui sont le résultat de décennies d’innovations acharnées. C’est en regardant ces machines que je me dis que nous vivons vraiment une époque extraordinaire en termes de progrès technologiques.

La révolution du transistor : Le petit géant qui a tout changé

Sincèrement, le transistor, c’est pour moi l’une des inventions les plus importantes de l’humanité, l’équivalent moderne de la roue ou du feu, du moins dans le monde de la technologie ! Quand on y pense, la découverte de ses propriétés semi-conductrices a ouvert la voie à une ère complètement nouvelle, celle de la miniaturisation et de la fiabilité. Soudain, ces gros tubes à vide, gourmands en énergie et fragiles, ont commencé à paraître obsolètes face à ces minuscules composants. Je me souviens d’avoir lu des témoignages d’ingénieurs qui, en découvrant le transistor, ont immédiatement compris l’ampleur de la révolution qui se profilait. C’était un sentiment d’excitation palpable, une impression que tout devenait possible. Et ils avaient raison ! La taille de nos appareils, leur consommation d’énergie, leur coût : tout a été radicalement transformé grâce à cette petite merveille. C’est ce qui a permis l’explosion de l’électronique grand public, rendant la technologie accessible à tous. Sans le transistor, votre smartphone ne serait qu’un rêve lointain, et nos vies seraient bien différentes. C’est un peu comme le cœur battant de la modernité.

La naissance du semi-conducteur : Une avancée majeure

La découverte du transistor, et plus largement des propriétés des matériaux semi-conducteurs comme le silicium, a été un véritable tournant. En 1947, chez Bell Labs, Brattain, Bardeen et Shockley ont mis au point le premier transistor à pointe, une invention qui leur vaudra le prix Nobel. Ce n’était plus une question de faire passer un courant par le vide, mais de contrôler son flux au sein d’un matériau solide. Cela a permis des appareils bien plus petits, plus rapides, et qui chauffaient beaucoup moins. C’était comme passer d’une locomotive à vapeur à un train à grande vitesse. Pour les ingénieurs de l’époque, c’était un champ de possibilités insoupçonné qui s’ouvrait, et la course à la miniaturisation était lancée !

Miniaturisation et fiabilité accrues : Les promesses tenues

L’un des avantages les plus spectaculaires du transistor fut sa capacité à être produit en masse, à des coûts de plus en plus bas, et surtout, à être intégré dans des espaces de plus en plus restreints. Sa robustesse, comparée à celle des tubes à vide, a également considérablement amélioré la fiabilité des appareils électroniques. Imaginez, on pouvait désormais créer des circuits complexes sans la crainte constante de devoir remplacer un composant défectueux. Cela a conduit à la démocratisation de l’électronique, avec l’apparition de radios portables, de télévisions plus compactes, et bien sûr, des premiers ordinateurs personnels. J’ai un ami qui est un collectionneur de vieilles radios, et il me raconte souvent comment le passage des tubes aux transistors a été une véritable révolution pour la portabilité et la qualité du son. C’est un aspect que l’on oublie parfois, mais le confort d’utilisation a été démultiplié.

L’ère des circuits intégrés : Quand l’invisible devient puissant

Ah, les circuits intégrés ! Pour moi, c’est là que la magie a vraiment commencé à opérer à grande échelle. On est passé de l’assemblage de composants individuels à la fabrication de tout un circuit sur une seule et même petite plaquette de silicium. C’est comme si on avait miniaturisé toute une ville pour la faire tenir dans le creux de la main ! J’ai toujours été fascinée par le fait qu’autant de complexité puisse être concentrée sur une si petite surface. Pensez au premier circuit intégré par Jack Kilby en 1958 : c’était une avancée monumentale qui a posé les bases de tout ce qui allait suivre. Cela a non seulement réduit la taille des appareils de manière drastique, mais a aussi amélioré leur performance et leur efficacité énergétique. Je me souviens de mes premiers contacts avec des circuits imprimés, enfant, essayant de comprendre ce réseau complexe de pistes et de composants. C’est un monde entier qui se cache sous nos yeux, et cette densité de calcul est ce qui rend possible la puissance de traitement de nos machines actuelles. C’est une véritable prouesse d’ingénierie qui continue de me surprendre chaque jour.

La naissance du circuit intégré : Un bond de géant

L’idée de regrouper plusieurs transistors, résistances et condensateurs sur un même support semi-conducteur a été une illumination. Le circuit intégré (CI) a permis de simplifier la fabrication, de réduire les coûts, d’augmenter la vitesse de fonctionnement et de diminuer considérablement la taille des systèmes électroniques. C’est l’étape qui a vraiment rendu possible l’informatique personnelle. Ce fut un bouleversement comparable à l’invention de l’imprimerie pour le savoir. Grâce à lui, des milliers, puis des millions, et aujourd’hui des milliards de transistors peuvent coexister sur une seule puce. C’est tout simplement vertigineux et cela continue d’évoluer à une vitesse folle. Imaginez la complexité de concevoir de telles puces, chaque ingénieur étant un architecte de l’infiniment petit. J’admire la patience et la précision que cela demande.

La loi de Moore et ses implications : Toujours plus petit, toujours plus vite

La fameuse loi de Moore, formulée par Gordon Moore en 1965, a prédit que le nombre de transistors sur une puce doublerait environ tous les deux ans. Et étonnamment, cette prédiction s’est maintenue pendant des décennies, devenant un moteur puissant de l’innovation dans l’industrie. C’est une prophétie auto-réalisatrice qui a poussé les ingénieurs à repousser constamment les limites de la miniaturisation. Elle a conduit à des augmentations exponentielles de la puissance de calcul et à des réductions de coûts, rendant l’électronique de plus en plus accessible. Mais cette loi est aujourd’hui remise en question, non pas parce que l’innovation s’arrête, mais parce que les limites physiques commencent à être atteintes. C’est fascinant de voir comment une simple observation est devenue le catalyseur d’une révolution technologique durable. C’est un peu le phare qui a guidé l’industrie pendant des générations.

L’ascension de la microélectronique : Vers l’infiniment petit

Franchement, quand on parle de microélectronique, on entre dans un domaine où l’échelle humaine n’a plus vraiment de sens. Nous parlons de gravure de circuits à l’échelle nanométrique, où chaque transistor est plus petit qu’un virus ! C’est hallucinant de penser à la précision requise pour fabriquer ces composants qui sont à la base de nos smartphones et de nos ordinateurs. La microélectronique, c’est le pilier invisible qui soutient notre monde numérique. J’ai eu la chance de visiter un laboratoire où l’on fabriquait ces puces, et le niveau de propreté et de précision est absolument ahurissant. C’est un environnement stérile, où la moindre poussière peut ruiner une plaquette entière. On se rend compte à quel point chaque étape de fabrication est un défi technologique en soi. Cette quête de l’infiniment petit n’est pas seulement une prouesse technique, c’est aussi ce qui nous permet d’avoir des appareils toujours plus performants, plus économes en énergie et plus compacts. C’est une course sans fin à l’innovation, où chaque génération de puces surpasse la précédente de manière spectaculaire.

Les fonderies de puces : Des usines du futur

La fabrication des circuits intégrés modernes se déroule dans des fonderies de puces, ou “fabs”, des installations d’une complexité et d’un coût astronomiques. Ces usines utilisent des techniques de lithographie avancées pour graver des milliards de transistors sur une seule tranche de silicium. L’environnement doit être d’une propreté absolue, à tel point que l’air y est des milliers de fois plus pur que celui d’un bloc opératoire. La fabrication est un processus long et complexe, impliquant des centaines d’étapes. C’est un ballet technologique où chaque machine joue un rôle précis pour créer ces merveilles de l’ingénierie. C’est un secteur d’activité qui demande des investissements colossaux, mais qui est absolument vital pour l’économie mondiale. Quand je vois le prix d’une de ces machines de lithographie, qui peut atteindre plusieurs centaines de millions d’euros, je me dis que c’est un investissement dans l’avenir de l’humanité.

L’impact sur l’électronique grand public : Une démocratisation sans précédent

L’avènement de la microélectronique a eu un impact colossal sur l’électronique grand public. C’est elle qui a rendu possible l’existence des ordinateurs personnels, des téléphones mobiles, des consoles de jeux vidéo et de tous les objets connectés que nous utilisons quotidiennement. Sans cette capacité à intégrer des millions, voire des milliards de fonctions sur une seule puce, nos appareils seraient encore des machines encombrantes et coûteuses, inaccessibles au commun des mortels. Elle a démocratisé l’accès à la technologie, transformant radicalement nos modes de vie et nos interactions sociales. Aujourd’hui, un smartphone a plus de puissance de calcul que les superordinateurs d’il y a quelques décennies, et c’est entièrement grâce aux progrès de la microélectronique. C’est ce qui m’enthousiasme le plus : la technologie devient un véritable prolongement de nous-mêmes.

| Époque/Technologie | Composants Clés | Caractéristiques Principales | Impact Majeur |

|---|---|---|---|

| Années 1940-1950 | Tubes à vide | Gros, chauffent, fragiles, chers | Premiers calculateurs électroniques (ENIAC), radio, télévision |

| Années 1950-1960 | Transistors | Petits, fiables, efficaces, moins chers | Miniaturisation des radios, ordinateurs plus petits, début de l’électronique grand public |

| Années 1960-1980 | Circuits intégrés (CI) | Plusieurs composants sur une puce, complexité accrue | Ordinateurs personnels, calculatrices, multiplication des fonctionnalités |

| Années 1980-Présent | Microprocesseurs (VLSI, ULSI) | Millions/Milliards de transistors sur une puce, puissance de calcul | Smartphones, IoT, intelligence artificielle, ubiquité de l’informatique |

Les défis contemporains : Énergie, taille et performance

Croyez-moi, même avec tous les progrès incroyables que nous avons faits, les ingénieurs d’aujourd’hui ne manquent pas de défis. La loi de Moore, bien qu’elle ait longtemps guidé l’industrie, rencontre désormais des limites physiques. On ne peut pas continuer à rendre les transistors indéfiniment plus petits sans rencontrer des problèmes fondamentaux. C’est là que l’innovation devient encore plus cruciale et complexe. Comment continuer à augmenter la puissance de calcul tout en réduisant la consommation d’énergie et la taille des puces ? C’est une véritable équation à plusieurs inconnues, et la réponse réside souvent dans des approches complètement nouvelles, comme l’architecture des puces ou l’utilisation de nouveaux matériaux. J’ai eu des discussions passionnantes avec des chercheurs qui travaillent sur ces questions, et leur ingéniosité est tout simplement époustouflante. Il ne s’agit plus seulement de rendre les choses plus petites, mais de les rendre plus intelligentes, plus efficaces et plus durables. C’est une ère où l’ingénierie et la physique quantique se rencontrent pour dessiner le futur.

Les limites de la miniaturisation : Repenser l’architecture

Alors que nous atteignons les limites physiques de la miniaturisation des transistors, les ingénieurs se tournent vers de nouvelles architectures de puces. Il ne s’agit plus seulement de “plus petits”, mais de “plus intelligents”. Des concepts comme les puces 3D empilées (3D stacking), où les circuits sont superposés verticalement, ou l’utilisation de matériaux exotiques et de nouvelles techniques de gravure sont à l’étude. Le défi est de maintenir l’efficacité énergétique tout en augmentant la densité et la vitesse. On explore aussi des architectures non traditionnelles, inspirées du cerveau humain, pour des calculs plus efficaces. C’est un domaine où la créativité est poussée à son paroxysme, car il faut trouver des solutions là où on pensait qu’il n’y en avait plus.

La gestion thermique et la consommation énergétique : Des enjeux cruciaux

Avec l’augmentation de la densité des transistors et de la puissance de calcul, la gestion de la chaleur et la consommation énergétique deviennent des préoccupations majeures. Un processeur puissant génère beaucoup de chaleur, ce qui peut nuire à ses performances et à sa durée de vie. Les ingénieurs doivent concevoir des puces et des systèmes de refroidissement toujours plus efficaces. Parallèlement, la consommation énergétique est un enjeu environnemental et économique important. Les efforts se concentrent sur la conception de circuits “low-power” et sur l’optimisation des algorithmes pour réduire l’empreinte énergétique. Personnellement, je trouve que c’est un défi passionnant, car il nous pousse à innover non seulement pour la performance, mais aussi pour la durabilité de notre planète. C’est une responsabilité que nous avons en tant qu’acteurs du monde de la technologie.

L’intégration de l’intelligence artificielle : Le cerveau dans la puce

Préparez-vous, car l’intégration de l’intelligence artificielle directement dans nos puces, c’est clairement l’une des tendances les plus excitantes du moment ! Imaginez des appareils qui ne se contentent pas d’exécuter des instructions, mais qui peuvent apprendre, s’adapter et même “penser” de manière autonome. On parle de puces conçues spécifiquement pour accélérer les calculs d’IA, que ce soit pour la reconnaissance vocale, la vision par ordinateur ou l’apprentissage automatique. C’est un peu comme donner un cerveau à nos machines, leur permettant de comprendre et d’interagir avec le monde de manière beaucoup plus intuitive. J’ai testé des applications qui utilisent ce type de puces, et la réactivité est bluffante. On sent que la machine ne se contente pas de répondre, elle “comprend” réellement ce qu’on lui demande. Cette intégration de l’IA au niveau matériel est ce qui va permettre des avancées spectaculaires dans des domaines aussi variés que la médecine, la robotique ou les véhicules autonomes. C’est une révolution qui est déjà en marche, et je suis impatiente de voir où cela va nous mener. C’est une période vraiment passionnante pour être un geek !

Les processeurs neuromorphiques : L’inspiration du cerveau

Les processeurs neuromorphiques sont une catégorie de puces conçues pour imiter la structure et le fonctionnement du cerveau humain. Au lieu d’utiliser l’architecture de von Neumann classique (avec une séparation entre la mémoire et le traitement), ces puces intègrent la mémoire et le calcul, comme le font les neurones et les synapses. L’objectif est de permettre un traitement des données massivement parallèle et une efficacité énergétique bien supérieure pour les tâches d’IA. C’est un domaine de recherche très actif et prometteur, qui pourrait révolutionner la façon dont nous concevons les systèmes d’intelligence artificielle, en les rendant plus agiles et moins gourmands en énergie. C’est comme si la nature nous donnait la solution pour les défis informatiques de demain.

L’accélération matérielle de l’IA : Vers plus d’autonomie

L’accélération matérielle de l’IA consiste à concevoir des circuits spécifiquement optimisés pour les algorithmes d’apprentissage automatique. Cela inclut les unités de traitement graphique (GPU), les unités de traitement tensoriel (TPU) et d’autres architectures dédiées. Ces puces permettent d’exécuter des modèles d’IA beaucoup plus rapidement et efficacement, ce qui est crucial pour des applications en temps réel comme la reconnaissance faciale, la traduction instantanée ou les systèmes de conduite autonome. Cette capacité à intégrer de l’intelligence directement dans l’appareil, sans dépendre constamment du cloud, ouvre la voie à des systèmes beaucoup plus autonomes, sécurisés et réactifs. Pour moi, c’est une étape clé vers un futur où nos objets du quotidien seront véritablement intelligents et non pas juste connectés.

L’avenir radieux : Innovations et perspectives

Alors, que nous réserve l’avenir dans le monde de la conception de circuits ? Honnêtement, si je devais parier, je dirais que nous sommes à l’aube de découvertes encore plus folles. Nous allons au-delà des limites actuelles avec des matériaux innovants comme le graphène ou les nanomatériaux, explorant les possibilités de l’informatique quantique, et même en nous penchant sur des approches biologiques pour créer des circuits vivants. C’est une période de mutation incroyable où les frontières entre la physique, l’informatique et la biologie s’estompent. Je suis particulièrement excitée par l’idée de circuits qui pourraient s’auto-réparer ou s’adapter à leur environnement, un peu comme des systèmes vivants. Imaginez un monde où la technologie est non seulement puissante et efficace, mais aussi résiliente et durable. C’est un futur où l’innovation est au service d’un monde meilleur, et où chaque avancée ouvre la porte à des possibilités que nous ne pouvons même pas encore imaginer. Accrochez-vous, car le meilleur est encore à venir, et nous en serons tous les témoins et les acteurs.

Les nouveaux matériaux et technologies de gravure : Au-delà du silicium

Pour dépasser les limites du silicium, les chercheurs explorent activement de nouveaux matériaux. Le graphène, avec ses propriétés électriques et thermiques exceptionnelles, est un candidat prometteur pour des transistors ultra-rapides et économes en énergie. Les nanomatériaux, les supraconducteurs et les matériaux ferroélectriques sont également à l’étude pour développer des mémoires plus denses et plus rapides. Les techniques de gravure évoluent aussi, avec la lithographie par ultraviolets extrêmes (EUV) qui permet de graver des motifs de plus en plus fins, repoussant encore les frontières de la miniaturisation. C’est une véritable course à l’innovation matérielle qui est en cours, et chaque découverte ouvre des portes vers des performances inédites.

L’informatique quantique et les circuits biomimétiques : Une nouvelle ère

L’informatique quantique, bien qu’encore à ses débuts, représente une rupture technologique majeure. Les qubits, les unités de base de l’information quantique, peuvent exister dans plusieurs états simultanément, permettant des calculs d’une complexité impensable pour les ordinateurs classiques. Bien que la conception de circuits quantiques soit extrêmement difficile, leur potentiel est immense pour la cryptographie, la modélisation moléculaire et la recherche pharmaceutique. Parallèlement, la biomimétique inspire la conception de circuits qui imitent les processus biologiques, comme les circuits auto-réparateurs ou les systèmes qui s’adaptent et apprennent de manière organique. Imaginez des puces qui pourraient “guérir” leurs propres défauts, ou évoluer pour répondre à de nouveaux besoins. C’est un futur où la technologie s’inspire de la vie, et cela me semble incroyablement prometteur.

Pour conclure

Alors voilà, chers amis passionnés, notre voyage à travers l’histoire fascinante de l’électronique touche à sa fin ! C’est incroyable de penser au chemin parcouru, n’est-ce pas ?

Des premiers tubes à vide, ces géants fragiles, aux puces nanométriques qui animent notre quotidien, chaque étape est une prouesse d’ingéniosité humaine.

On a vu comment la curiosité et la persévérance de ces pionniers ont littéralement transformé le monde, rendant l’impossible possible. Et ce n’est pas terminé !

Le futur nous promet encore des merveilles, avec l’IA intégrée, de nouveaux matériaux et peut-être même l’informatique quantique. C’est une aventure qui continue de s’écrire, et nous avons la chance d’en être les témoins privilégiés.

Gardons les yeux ouverts, car le meilleur est sûrement à venir !

Bon à savoir pour les passionnés d’électronique

1. Explorez les musées de la technologie : Si vous avez l’occasion, visitez un musée des sciences ou de la technologie. Voir ces vieux ordinateurs et tubes à vide en vrai donne une toute autre perspective sur les progrès accomplis. C’est comme remonter le temps !

2. Comprendre les bases : Pour vraiment apprécier la complexité de nos appareils modernes, essayez de vous familiariser avec les principes de base de l’électricité et des semi-conducteurs. Il existe plein de ressources en ligne pour les débutants, même pour ceux qui ne sont pas ingénieurs.

3. Ne jetez pas les vieux appareils : Avant de vous débarrasser d’un vieil appareil électronique, jetez-y un œil. Parfois, on peut y trouver des composants intéressants ou simplement admirer la conception d’une autre époque. Qui sait, ça peut inspirer votre prochain projet !

4. Suivez l’actualité de la microélectronique : Le domaine évolue à une vitesse folle ! Abonnez-vous à des blogs ou des magazines spécialisés pour rester informé des dernières innovations en matière de puces, de matériaux et d’IA. C’est passionnant de voir les nouvelles avancées en temps réel.

5. Expérimentez par vous-même : Si le cœur vous en dit, lancez-vous dans des petits projets d’électronique avec des cartes comme Arduino ou Raspberry Pi. C’est le meilleur moyen de comprendre concrètement comment les circuits fonctionnent et de laisser libre cours à votre créativité.

Points clés à retenir

L’électronique a connu une évolution fulgurante, passant des encombrants tubes à vide aux transistors miniatures, puis aux circuits intégrés et aux microprocesseurs. Chaque étape a permis une miniaturisation, une augmentation de la puissance et une réduction des coûts, démocratisant l’accès à la technologie. Aujourd’hui, les défis incluent les limites physiques de la miniaturisation et la gestion de l’énergie, tandis que l’intégration de l’intelligence artificielle et l’exploration de nouveaux matériaux et de l’informatique quantique ouvrent des perspectives d’avenir incroyables. C’est une histoire de constante innovation, façonnant le monde tel que nous le connaissons et celui de demain.

Questions Fréquemment Posées (FAQ) 📖

Q: Les débuts de la conception de circuits me fascinent ! Pourriez-vous nous éclairer sur les moments clés de son évolution et comment ils ont transformé nos vies ?

R: Oh là là, c’est une excellente question qui nous plonge directement au cœur de l’histoire de la tech ! Franchement, quand je me suis penché sur les archives, j’ai réalisé à quel point chaque étape était une prouesse.

Tout a vraiment commencé avec les tubes à vide, ces gros bulbes de verre que l’on trouvait dans les vieilles radios et les premiers ordinateurs. Ils ont ouvert la voie à l’électronique telle qu’on la connaît.

Mais la vraie révolution, celle qui a tout changé, c’est l’invention du transistor au Laboratoires Bell en 1947. Imaginez un peu : une minuscule pièce de semi-conducteur capable de faire le travail d’un tube à vide géant !

Ça a permis de rendre les appareils plus petits, plus fiables et moins gourmands en énergie. Puis, est arrivé le circuit intégré, la fameuse “puce”, qui a permis de grouper des milliers, puis des millions de transistors sur un seul petit morceau de silicium.

C’est grâce à ça qu’on a eu les premiers ordinateurs personnels dans les années 70 et 80, et plus tard, nos smartphones et tout ce qui fait notre quotidien numérique.

C’est une histoire incroyable de miniaturisation et de puissance croissante, qui a littéralement remodelé notre monde, de la communication aux loisirs en passant par la médecine.

J’ai personnellement eu l’occasion de manipuler d’anciens transistors, et la différence avec les puces actuelles est juste vertigineuse !

Q: Avec toutes ces avancées, quels sont aujourd’hui les plus grands défis techniques pour les ingénieurs en conception de circuits, et comment tentent-ils de les surmonter ?

R: C’est une question très pertinente, car on pourrait croire que tout est déjà inventé, n’est-ce pas ? Mais détrompez-vous, les ingénieurs sont confrontés à des défis de taille, et c’est ce qui rend ce domaine si excitant !

Le premier, et peut-être le plus connu, c’est la poursuite de la miniaturisation. On parle de la loi de Moore, qui dit que le nombre de transistors double environ tous les deux ans.

Mais on atteint des limites physiques, les atomes eux-mêmes commencent à poser problème ! Pour contourner ça, on voit apparaître des innovations comme l’empilement 3D des puces, où on ne fait plus des circuits “plats”, mais on les superpose comme des étages d’un immeuble pour gagner de la place et de la performance.

Ensuite, il y a la consommation d’énergie et la dissipation de chaleur : des milliards de transistors qui travaillent, ça chauffe ! Les puces sont conçues pour être de plus en plus économes, et on explore de nouveaux matériaux, comme les semi-conducteurs à large bande interdite, pour améliorer l’efficacité.

Et bien sûr, avec l’essor de l’intelligence artificielle, le défi est d’intégrer des capacités de calcul complexes directement dans la puce, avec des architectures spécialisées qu’on appelle ASIC ou des puces neuromorphiques qui imitent le cerveau humain.

Personnellement, quand j’ai vu un prototype de puce conçue pour l’IA, j’ai été bluffé par l’ingéniosité déployée pour gérer tant de données en un clin d’œil.

C’est un vrai casse-tête passionnant !

Q: Si on se projette dans le futur, quelles sont les tendances de conception les plus prometteuses et les innovations qui pourraient le plus impacter notre quotidien dans les années à venir ?

R: Ah, la boule de cristal de la technologie ! C’est ce que je préfère, car c’est là que l’imagination rejoint la science. Plusieurs tendances se dessinent clairement.

La première, c’est l’omniprésence de l’intelligence artificielle “à la périphérie”, c’est-à-dire directement dans nos objets du quotidien (Edge AI). On ne parlera plus seulement d’un smartphone intelligent, mais d’une maison, d’une voiture, voire de vêtements intelligents, tous équipés de puces capables de traiter l’information localement sans avoir besoin d’envoyer tout au cloud.

Cela va révolutionner la rapidité et la sécurité de nos interactions. Ensuite, il y a les circuits flexibles et extensibles. Imaginez des capteurs intégrés à même votre peau, des écrans que l’on peut plier et déplier à volonté, ou des dispositifs médicaux implantables qui s’adaptent parfaitement au corps humain.

C’est une rupture totale avec la rigidité actuelle de l’électronique. Et bien sûr, le graal, c’est l’informatique quantique. Même si on est encore loin d’une commercialisation massive, les avancées dans la conception de puces quantiques pourraient un jour résoudre des problèmes que même nos supercalculateurs actuels ne peuvent pas aborder, de la découverte de nouveaux médicaments à la cryptographie incassable.

Moi, ce qui me passionne le plus, c’est l’idée que les leçons d’hier façonnent les innovations de demain. On est à l’aube d’une ère où nos appareils seront encore plus intuitifs, réactifs et intégrés à notre environnement, pour une vie toujours plus simple et connectée.

La conception de circuits sera au cœur de toutes ces merveilles !